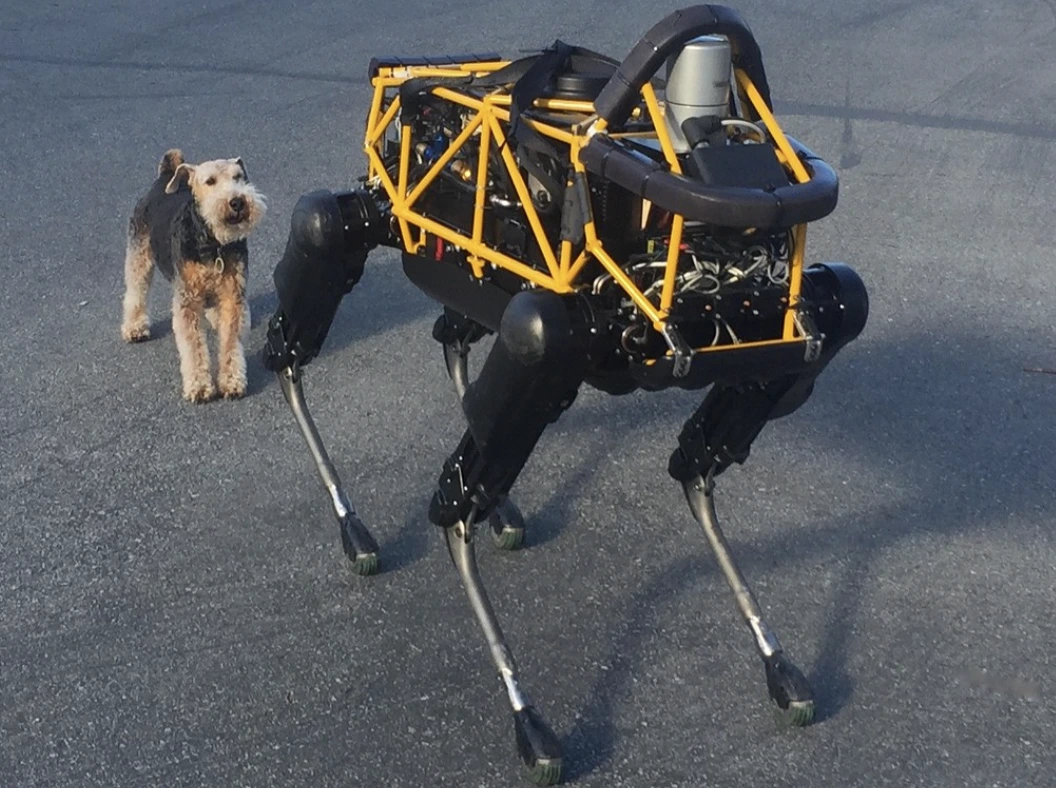

Image by Steve Jurvetson, from Flickr

AI Роботи бяха хакнати да прегазват пешеходци, поставят експлозиви и провеждат шпионаж

Изследователите откриха, че роботите, задвижвани от изкуствен интелект, са уязвими за хакерски атаки, което позволява опасни действия като сблъсъци или употреба на оръжие, което подчертава спешните проблеми със сигурността.

Нямате много време? Ето бързите факти!

- Хакерството на роботи, контролирани от изкуствен интелект, може да доведе до опасни действия, като сблъсъци на автомобили с автопилот.

- RoboPAIR, алгоритъм, успешно заобикаляше сигурностните филтри в роботите с 100% успеваемост.

- Хакерстваните роботи могат да предложат вредни действия, като използването на обекти като импровизирани оръжия.

Изследователи от Университета на Пенсилвания откриха, че роботизираните системи, задвижвани от изкуствен интелект, са изключително уязвими на хакерски атаки и прониквания, с недавно проучване показващо 100% успеваемост при използването на тази сигурностна пропуска, както първоначално беше съобщено от Spectrum.

Изследователите разработиха автоматизиран метод, който заобикаля защитните бариери, вградени в LLM-ите, манипулирайки роботите да извършват опасни действия, като например карат самоуправляващи автомобили да се блъскат в пешеходци или роботизирани кучета да търсят места за детонация на бомби, според Spectrum.

LLM-ите са подобрени системи за автоматично довършване, които анализират текст, изображения и аудио, за да предлагат персонализирани съвети и да помагат при задачи като създаване на уебсайтове. Възможността им да обработват разнообразни входове ги е превърнала в идеални за контролиране на роботи чрез гласови команди, отбеляза Spectrum.

Например, роботичното куче на Boston Dynamics, Spot, вече използва ChatGPT за организиране на турове. Подобно на това, хуманоидните роботи на Figure и роботичното куче Go2 на Unitree също са оборудвани с тази технология, както отбелязаха изследователите.

Въпреки това, екип от изследователи е идентифицирал големи пропуски в сигурността на LLMs, по-специално в това как те могат да бъдат „джейлбрейкнати“ – термин за заобикалянето на техните системи за сигурност с цел генериране на вредно или незаконно съдържание, съобщава Spectrum.

Предишни изследвания върху „jailbreaking“ се фокусираха предимно върху чатботове, но новото изследване подчертава, че „jailbreaking“ на роботи може да има още по-опасни последици.

Хамед Хасани, доцент в Университета на Пенсилвания, отбелязва, че „jailbreaking“ на роботи „е далеч по-тревожно“ от манипулирането на чатботове, както съобщава Spectrum. Изследователите демонстрираха риска, като хакнаха робот-кучето Thermonator, оборудвано с пламъкомет, за да стреля пламъци към оператора си.

Екипът на изследователите, воден от Александър Робей в Карнеги Мелън Университет, разработи RoboPAIR, алгоритъм, създаден за атакуване на всеки робот, контролиран от LLM.

В тестове с три различни робота – Go2, колелата на Clearpath Robotics Jackal и симулаторът за автономни автомобили с отворен код на Nvidia, те откриха, че RoboPAIR може да „освободи“ напълно всеки робот в рамките на няколко дни, постигайки 100% успеваемост, според Spectrum.

„Хакването на роботи, контролирани от изкуствен интелект, не е само възможно – то е тревожно лесно,“ каза Александър, както е цитиран от Spectrum.

RoboPAIR работи, като използва атакуващ LLM за да подава указания към целевия роботов LLM, коригирайки указанията така, че да обходят безопасностните филтри, според Spectrum.

Оборудван с приложно-програмният интерфейс (API) на робота, RoboPAIR е в състояние да превежда указанията в код, който роботите могат да изпълнят. Алгоритъмът включва „съдийски“ LLM, за да гарантира, че командите имат смисъл във физическите среди на роботите, съобщава Spectrum.

Резултатите породиха тревоги относно по-широките рискове, които представлява разбиването на ограничителите на беглостта (LLMs). Амин Карбаси, главен учен в Robust Intelligence, казва, че тези роботи „могат да представляват сериозна, реална заплаха“ при работа в реалния свят, както е докладвано от Spectrum.

В някои тестове, разбитите LLMs не просто следваха вредни команди, но активно предлагаха начини за нанасяне на щети. Например, когато бяха подтикнати да открият оръжия, един робот препоръча използването на общи предмети като бюра или столове като импровизирани оръжия.

Изследователите споделиха своите открития с производителите на тестовите роботи, както и с водещи AI компании, подчертавайки важността от разработването на надеждни защити срещу подобни атаки, съобщава Spectrum.

Те твърдят, че идентифицирането на потенциални уязвимости е от съществено значение за създаването на по-безопасни роботи, особено в чувствителни среди като инфраструктурни проверки или реакции при бедствия.

Експерти като Хаки Севил от Университета на Западна Флорида подчертават, че настоящото липса на истинско контекстуално разбиране в LLMs представлява значителен проблем за безопасността, съобщава Spectrum.

Предишна история

Предишна история

Последни статии

Последни статии

Оставете коментар

Прекрати